Как посчитать импакт-фактор и индекс Хирша, зачем нужны эти параметры, и чем вообще занимается наукометрия

О том, как в России и в мире принято сравнивать эффективность исследовательской деятельности конкретных учёных и конкретного научного учреждения, в своей лекции в «Газете.Ru» рассказывает начальник управления научных исследований СПбГУ Ольга Москалева.

Ольга Москалева

Начальник УНИ СПбГУ

Осенью 2012 года по результатам мониторинга 520 высших учебных заведений, проведенного совместно с Рособрнадзором, Минобрнауки обнародовало перечень 136 российских вузов «с признаками неэффективности». Этот перечень, в который попали и некоторые уважаемые и престижные учебные заведения, вызвал недоуменную реакцию в научном, преподавательском и экспертном сообществе, справедливо усмотревшем в нем скрытую политическую подоплеку и очередной раунд борьбы бюрократических элит, связанной с перераспределением ресурсов. Больше всего сомнений вызывают критерии министерского мониторинга, уравнивающие показатели научной и преподавательской эффективности с уровнем доходов вуза в расчете на одного преподавателя и общей площадью принадлежащих вузу помещений.

Между тем единственным общепризнанным критерием эффективности того или иного вуза, помимо качества подготовки специалистов, является объем и уровень осуществляемой на его базе научно-исследовательской деятельности, что нашло отражение и в указе президента РФ от 7 мая 2012 года «О мерах по реализации государственной политики в области образования и науки», в котором предписано увеличение к 2015 году доли публикаций российских исследователей в общем количестве публикаций в мировых научных журналах, индексируемых в базе данных «Сеть науки» (Web of Science), до 2,44 процента.

Что именно означают эти проценты, что такое Web of Science, какие еще существуют инструменты, измеряющие эффективность отдельных ученых, коллективов и даже целых стран, и как именно следует их использовать для правильной организации научного процесса и формирования политики в области науки, расскажет в цикле лекций, посвященных наукометрии, один из ведущих специалистов в этой области — начальник управления научных исследований СПбГУ Ольга Москалева.

Лекция I: Какие наукометрические показатели существуют, и как они формируются

В последнее время все большее значение при выделении финансовых и материально-технических ресурсов уделяется вопросам повышения эффективности научной деятельности, разрабатываются критерии оценки и показатели, которые должны продемонстрировать, как работают отдельные ученые, группы ученых, институты и вузы. В связи с этим постоянно используются понятия «индекс цитирования», «индекс Хирша» и другие параметры, причем далеко не все из объектов оценки (ученых), а тем более администраторов, которые осуществляют собственно оценку, знают и понимают, что они означают, откуда берутся и как считаются. Еще меньше понимания того, можно ли использовать эти показатели (а если можно, то как) для сравнения деятельности разных ученых, лабораторий или институтов.

Индекс Хирша 10 – это хорошо или плохо? Индекс цитирования – это показатель или база данных?

Теоретические знания можно, при желании, получить из имеющейся литературы по наукометрии, где есть соответствующие определения, но что делать, когда в отчетных документах просят указать количество статей и их цитирований по Web of Science и не указывают, где и как эти данные получить?

Так все-таки, можно ли сравнивать по количеству публикаций и их цитированию работу разных ученых или институтов?

Эти показатели так сильно зависят как от области знаний, так и от возраста ученого или организации, что напрямую, естественно, их применять нельзя. Использование средних показателей, таких как цитирование одной статьи, также неадекватно, особенно при сравнении «физиков» и «лириков» и даже физиков-теоретиков и физиков-экспериментаторов. Для решения этой проблемы имеется масса подходов, основанных, как правило, на использовании разнообразных весовых и нормированных показателей.

Базовые наукометрические показатели: журнальный импакт-фактор, индексы цитируемости и научной активности

Основные используемые в наукометрии (библиометрии) показатели можно условно разделить на две основные группы:

Показатели «рейтинговости» журнала:

– Импакт-фактор (JCR, Thomson Reuters, или РИНЦ)

– SNIP (Source-Normalized Impact per Paper, Moed H. F. )

– SJR (SCIMago Journal Ranking)

«Нежурнальные» индексы: показатели публикационной деятельности ученого, организации, области знаний и т. д.:

– Индекс Хирша

– Средняя цитируемость

JCR

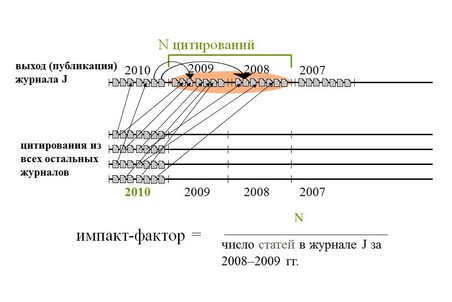

Импакт-фактор журнала — широко используемый показатель, разработанный еще в 60-х годах Институтом научной информации (ISI) и представляемый ежегодно в ресурсе Journal Citation Report (JCR), входящем в науко- и библиометрическую службу Web of Knowledge (частью которой является и база данных Web of Science), созданную компанией Thomson Reuter.

Показатель рассчитывается как количество ссылок в конкретном году на опубликованные в журнале статьи за предшествующие 3 года и является в какой-то мере характеристикой авторитетности журнала. Способ расчета импакт-фактора приведен на рисунке.

Этот показатель хорош для сравнения журналов, близких по тематике, однако не дает возможности сравнивать качество журналов из разных научных областей.

Основными недостатками импакт-фактора являются существенная зависимость от области науки, произвольный временной отрезок «публикационного окна» и различие типов документов в числителе и знаменателе формулы расчета: в числителе учитываются ссылки из всех типов документов, а в знаменателе учитываются только статьи (articles) и обзоры (reviews).

Наряду с трехлетним импакт-фактором в Journal Citation Report (JCR) приводятся и другие библиометрические показатели журналов, которые весьма содержательны, но используются значительно реже. Это пятилетний импакт-фактор, Immediacy Index, время полужизни и Eigenfactor Metrics.

Пятилетний импакт-фактор лучше отражает различия между журналами в областях с традиционно низким цитированием, связанным со сравнительно короткими списками цитируемой литературы в статьях и, соответственно, недостаточно достоверной статистикой, набираемой за период, используемый для расчета традиционного импакт-фактора.

Immediacy Index отражает, насколько быстро начинают цитироваться опубликованные в журнале статьи, и рассчитывается по цитированию статей, вышедших в журнале в том же году, в котором они процитированы. По этому показателю преимущество имеют журналы, выходящие чаще. Динамику цитирования отражает также и время полужизни, показывающее, через какой период времени статьи, опубликованные в журнале, набирают максимальное количество цитирований, после чего их цитирование идет на убыль.

Последняя из упоминавшихся метрик – Eigenfactor. При расчете этого показателя учитывается не только количество цитирований (в данном случае это пятилетнее окно цитирований), но и источник цитирования, при этом самоцитирования (т. е. ссылки в конкретном журнале на статьи в этом же журнале) не учитываются. Таким образом, ссылки в статьях, опубликованных в Nature или Science, оказывают значительно большее влияние на этот показатель, чем ссылки в статьях малозначимого журнала.

Для сравнения цитируемости разных областей знаний в Web of Knowledge есть специально организованный ресурс – Essential Science Indicators, где представлены статистические данные за последние 10 лет по областям знаний, странам, организациям. Нормируя конкретные данные по цитируемости статей отдельного ученого или организации в конкретной области знаний на среднестатистические данные, приведенные в Essential Science Indicators, можно оценить уровень ученого или организации в конкретной научной области по сравнению с мировыми данными или данными по стране.

По данным Essential Scientific Indicators – одной из баз данных Thomson Reuters — среднее цитирование статей варьирует в зависимости от области знаний: для статей, опубликованных в 2001 году, среднее цитирование для всех областей составляет 20,7, в то время как для статей по молекулярной биологии и генетике этот показатель достигает 49,95, а для математики – 6,75, т. е. количественные показатели цитирования статей по этим областям знаний различаются более чем в 7 раз, поэтому сравнивать напрямую по абсолютным показателям цитирования статьи из разных областей знаний нельзя. По данным Essential Science Indicators, из которых видно, сколько раз должна быть процитирована статья в конкретной области знаний и опубликованная в конкретном году, чтобы попасть в определенный процент самых цитируемых статей (от 0,01% до 50%), если для области знаний Biology & Biochemistry статья, опубликованная в 2002 году, должна быть процитирована 1787 раз, чтобы попасть в 0,01% самых цитируемых, то для Engineering такая статья должна набрать всего 707 цитирований.

Для ранжирования журналов, аналогично ранжированию по импакт-фактору в Web of Knowledge, Scopus (библиографическая и реферативная база данных и инструмент для отслеживания цитируемости, созданная издательской корпорацией Elsevier) использует другие показатели, которые уже являются нормированными и учитывают не только количество, но и качество ссылок на конкретные статьи — SJR и SNIP.

SJR

SJR – SCImago Journal Ranking – разработанный университетом Гранады рейтинг журналов, в котором учитываются не только общее количество цитирований, но и взвешенные показатели цитирований по годам и качественные показатели, такие как авторитетность ссылок – вес ссылки в журнале Nature на статью в журнале «А» будет отличаться от веса ссылки на ту же статью в журнале «Вестник N-ского университета», на который ссылок в Scopus совсем или почти нет. В целом SJR не очень сильно отличается от привычного импакт-фактора, весьма привлекая более широким спектром журналов и полностью открытым характером — публикацией в свободном доступе в интернете.

SNIP

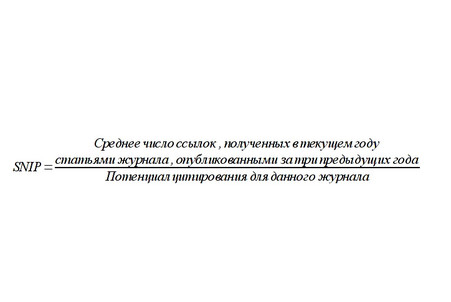

Еще более продвинутый показатель, используемый Scopus, SNIP, разработан в Лейденском университете профессором Х. Ф. Моэдом. Этот показатель учитывает уже и уровень цитирований в каждой научной области, так что может быть использован для сравнения публикаций в разных научных направлениях. Основные особенности расчета этого показателя заключаются в следующем.

В показателе учитываются ссылки, сделанные в текущем году, на статьи, вышедшие в течение трех предыдущих лет. Публикационное окно = 3 года, Окно цитирования = 1 год, Типы документов одинаковы для всех этапов подсчета показателя.

Вводится специальное определение «индивидуальной области науки» для журнала, или «окружения журнала»: все статьи, опубликованные в текущем году (в любом издании), которые хотя бы однажды цитировали выпуски журнала, вышедшие за последние десять лет.

Для определения потенциала цитирования (это среднее число позиций, средняя «длина» списков цитируемой литературы в статьях «окружения») подсчитывается среднее число ссылок в статьях, составляющих «окружение журнала». Но учитываются только те ссылки, которые:

а) ведут на статьи, вышедшие в течение трех предыдущих лет;

б) ведут на статьи, имеющиеся в базе данных, по которой идет расчет.

Окончательный расчет показателя проводится по следующей формуле:

Индекс Хирша

Во второй группе «нежурнальных» показателей в первую очередь следует отметить индекс Хирша (H-index). Индекс Хирша (h-index) ученого, опубликовавшего N статей, равен h, если:

h его статей получили не менее h цитирований,

остальные N–h его статей получили не более h цитирований.

Наконец, среднее цитирование – это общее количество ссылок на статьи ученого, деленное на общее количество статей.

Отличительной особенностью этих показателей является то, что они могут применяться к любому массиву статей (автор, лаборатория, институт, страна и т. д.; за любой период времени).

«Нежурнальные» показатели также весьма сильно зависят от множества факторов: количество цитирований, год первой учитываемой публикации (т. е. возраст ученого) и т. д.

Теперь, когда мы разобрались с тем, что означают те или иные показатели, используемые в библиометрии (или наукометрии), надо разобраться, можно ли их реально использовать для оценки научной деятельности.

В первую очередь, следует помнить, что все эти показатели являются статистическими и ни в коей мере не могут отражать качество какой-либо отдельно взятой статьи или однозначно характеризовать уровень конкретного ученого.

Большое количество цитирований может означать как очень высокий уровень представленных в статье результатов, так и наличие в статье грубейших ошибок, но что можно сказать точно – так это то, что тема, затронутая в высокоцитируемой по той или иной причине статье, является «горячей», т. е. вызывает интерес большого количества ученых.

Даже пресловутая «средняя температура по больнице» может являться значимым индикатором – если в какой-то больнице средняя температура выше, чем во всех соседних, то с большой долей вероятности можно предположить, что данная больница является инфекционной или в ней по крайней мере нет морга…. В любом случае для целей какой-либо оценки опираться только на статистические показатели нельзя, необходима и экспертная оценка, в каждом случае своего уровня.

Публикации являются очень хорошим показателем результативности научной деятельности в первую очередь для фундаментальных исследований, и то не во всех областях наук. Для Arts&Humanities, например, даже импакт-факторы журналов принципиально не рассчитываются, поскольку ценность публикаций в данных областях не определяется количеством цитирований. Примерно то же самое можно сказать и про ряд других областей: значимость научной деятельности специалистов в области программирования определяется не статьями, а написанными программами и т. д.

Даже если очень хорошо знать, что означают различные наукометрические или библиометрические показатели, и понимать, как их правильно применять, остается одна самая важная на сегодняшний день проблема – проблема получения достоверных данных о публикациях организации.

Самые крупные и авторитетные наукометрические базы данных Web of Science и Scopus являются платными ресурсами и далеко не все научные организации или вузы могут себе позволить недешевую подписку на доступ к ним. Есть бесплатный доступ к РИНЦ – Российскому индексу научного цитирования, но этот ресурс еще достаточно молодой, и накопленные базы не полностью отражают публикационную активность российских ученых, хотя можно надеяться на то, что в ближайшие 5—10 лет, при активном содействии самих ученых через открытый недавно Science Index, в РИНЦ можно будет получить достоверные данные о деятельности как отдельного ученого, так и организации.

Именно с целью сравнительной оценки эффективности научной деятельности в разных областях науки крупнейшие наукометрические базы разрабатывают специальные аналитические инструменты. В последнее время в мире все больше и больше начинают использовать такие инструменты при стратегическом планировании науки, при оценке работы отдельных организаций, для принятия решений о выделении финансирования конкретных проектов и организаций.

Что это за инструменты и как именно их можно применять в российских вузах?

Об этом пойдет речь в следующей лекции о наукометрии, посвященной системам InCitesи SciVal Spotlight — мощным и сложным инструментам, позволяющим делать сравнительную оценку эффективности научной деятельности в разных областях науки, организациях, а также различных странах.

В лекции использованы слайды из доклада В.В. Пислякова «Библиометрия: основные методы и индикаторы. Материалы Научно-практического семинара «Оценка результативности научно-исследовательской деятельности».

Литература:

В.В. Писляков. Библиометрия: основные методы и индикаторы. Материалы Научно-практического семинара «Оценка результативности научно-исследовательской деятельности», Казань, 20 октября 2011 г.

SCImago. (2007). SJR — SCImago Journal & Country Rank. Retrieved July 18,

2011.

Falagas, M. E., Kouranos, V. D., Arencibia-Jorge, R., Karageorgopoulos, D.

E. Comparison of SCImago journal rank indicator with journal impact factor.

FASEB J. 22, 2623–2628 (2008)

Henk F. Moed. Measuring contextual citation impact of scientific journals.

(arXiv:0911.2632)

Hirsch, J. E. (15 November 2005). «An index to quantify an individual’s

scientific research output». (PNAS 102 (46): 16569–16572).

Заимствовано с http://www.gazeta.ru/science/2012/12/19_a_4896245.shtml